SCW Trust Agent: AI

Vollständige Transparenz und Kontrolle über KI-generierten Code. Schnell und sicher innovieren.

%201.avif)

Verbesserung der Produktivität,

aber Erhöhung des Risikos

Die weit verbreitete Einführung von KI-Codierungstools, LLMs und MCPs stellt eine neue Herausforderung dar: mangelnde Transparenz und Kontrolle über KI-generierten Code.

78%

- StackOverflow

30%

- arXiv

50%

- BaxBench

Die Vorteile von Trust Agent: AI

Die neuen KI-Funktionen von SCW Trust Agent bieten Ihnen die umfassende Beobachtungsmöglichkeit und Kontrolle, die Sie benötigen, um die Einführung von KI in Ihrem Softwareentwicklungszyklus (SDLC) ohne Sicherheitseinbußen zu bewältigen.

Die Herausforderung von AI in Ihrem SDLC

Ohne eine Möglichkeit, die KI-Nutzung zu verwalten, sind CISOs, AppSec- und Technikverantwortliche neuen Risiken und Fragen ausgesetzt, die sie nicht beantworten können. Einige der Bedenken sind:

- Mangelnder Überblick darüber, welche Entwickler welche Modelle verwenden.

- Ungewissheit über die Sicherheitskenntnisse von Entwicklern, die KI-Codierungstools verwenden.

- Es gibt keine Erkenntnisse darüber, wie viel Prozent des beigetragenen Codes KI-generiert ist.

- Unfähigkeit, Richtlinien und Governance durchzusetzen, um das Risiko von KI-Codierungswerkzeugen zu verwalten.

Unsere Lösung -

Trust Agent: AI

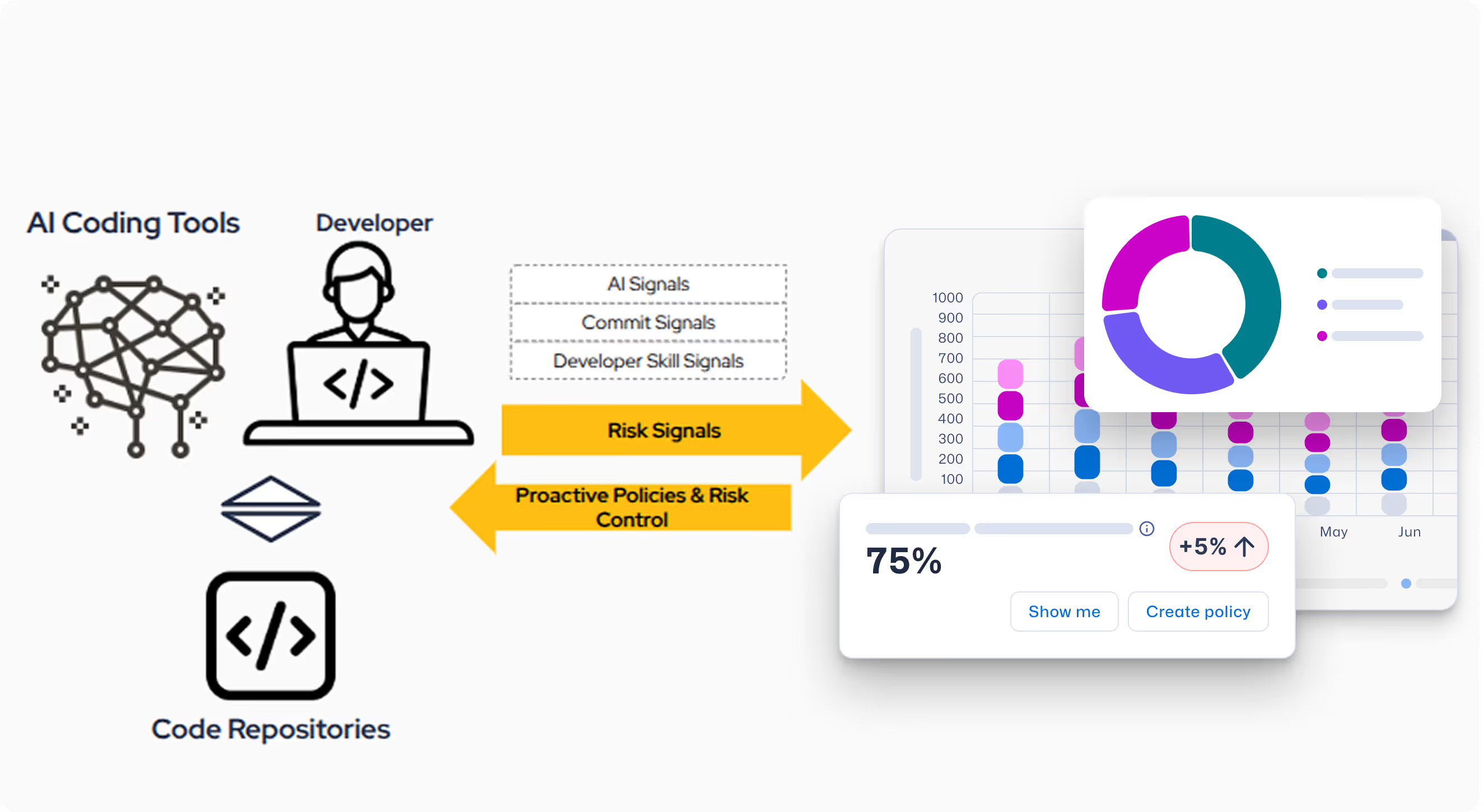

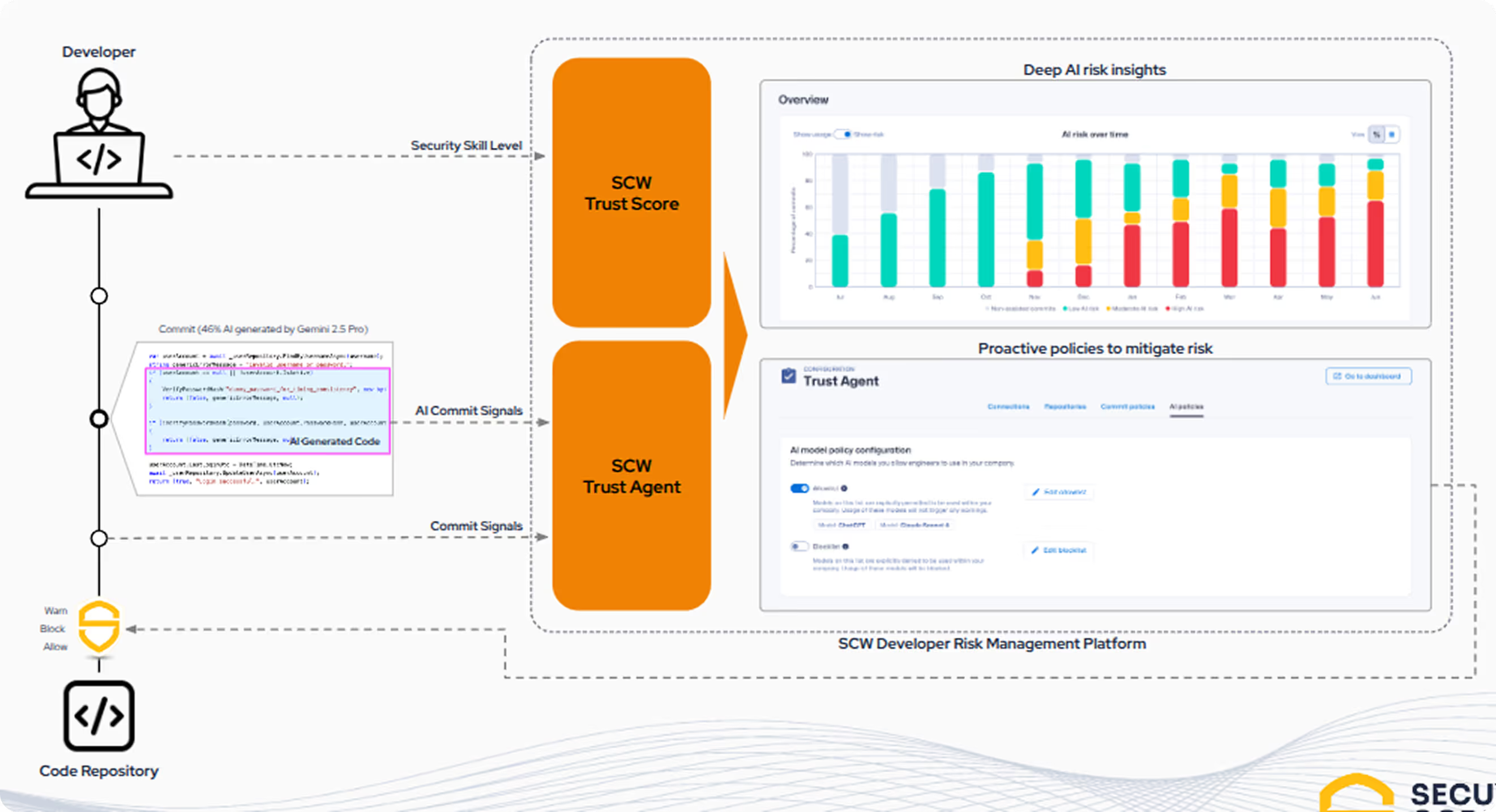

SCW ermöglicht es Unternehmen, die Geschwindigkeit der KI-gesteuerten Entwicklung zu nutzen, ohne Abstriche bei der Sicherheit zu machen. Trust Agent: AI ist die erste Lösung, die Transparenz und Governance bietet, indem sie eine einzigartige Kombination aus drei Schlüsselsignalen korreliert, um das KI-gestützte Entwicklerrisiko auf der Commit-Ebene zu verstehen.

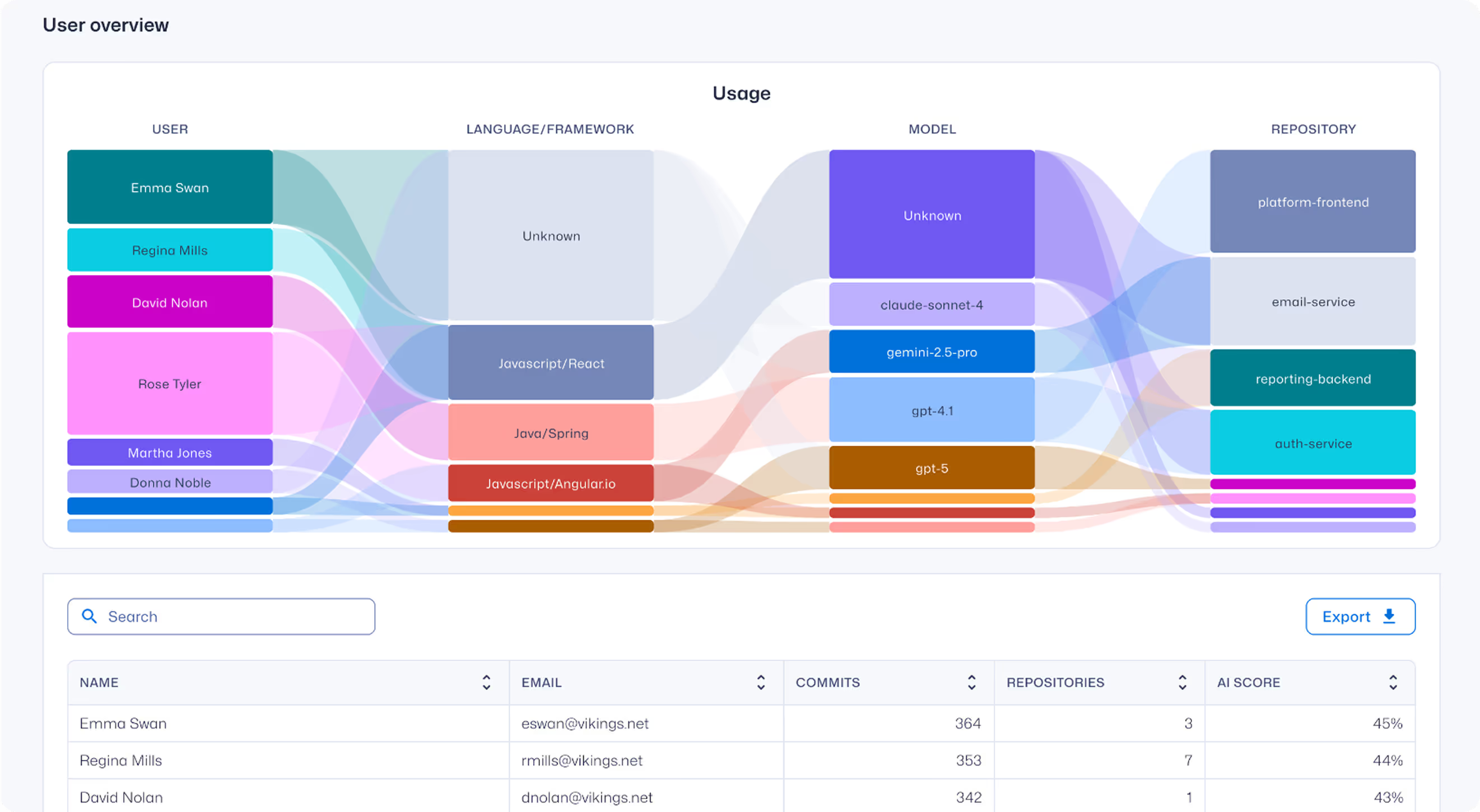

- Nutzung von KI-Codierungstools: Einblicke darin, wer welche KI-Codierungstools, LLMs und MCPs nutzt – und in welchen Code-Repositorys.

- Signale werden in Echtzeit erfasst: Vertrauensagent: KI fängt KI-generierten Code auf dem Computer und der IDE des Entwicklers ab.

- Sichere Kodierungsfähigkeiten der Entwickler: Wir bieten ein klares Verständnis der sicheren Programmierfähigkeiten eines Entwicklers, die die Grundlage für einen verantwortungsvollen Umgang mit KI bilden.

Keine "Schatten-KI" mehr

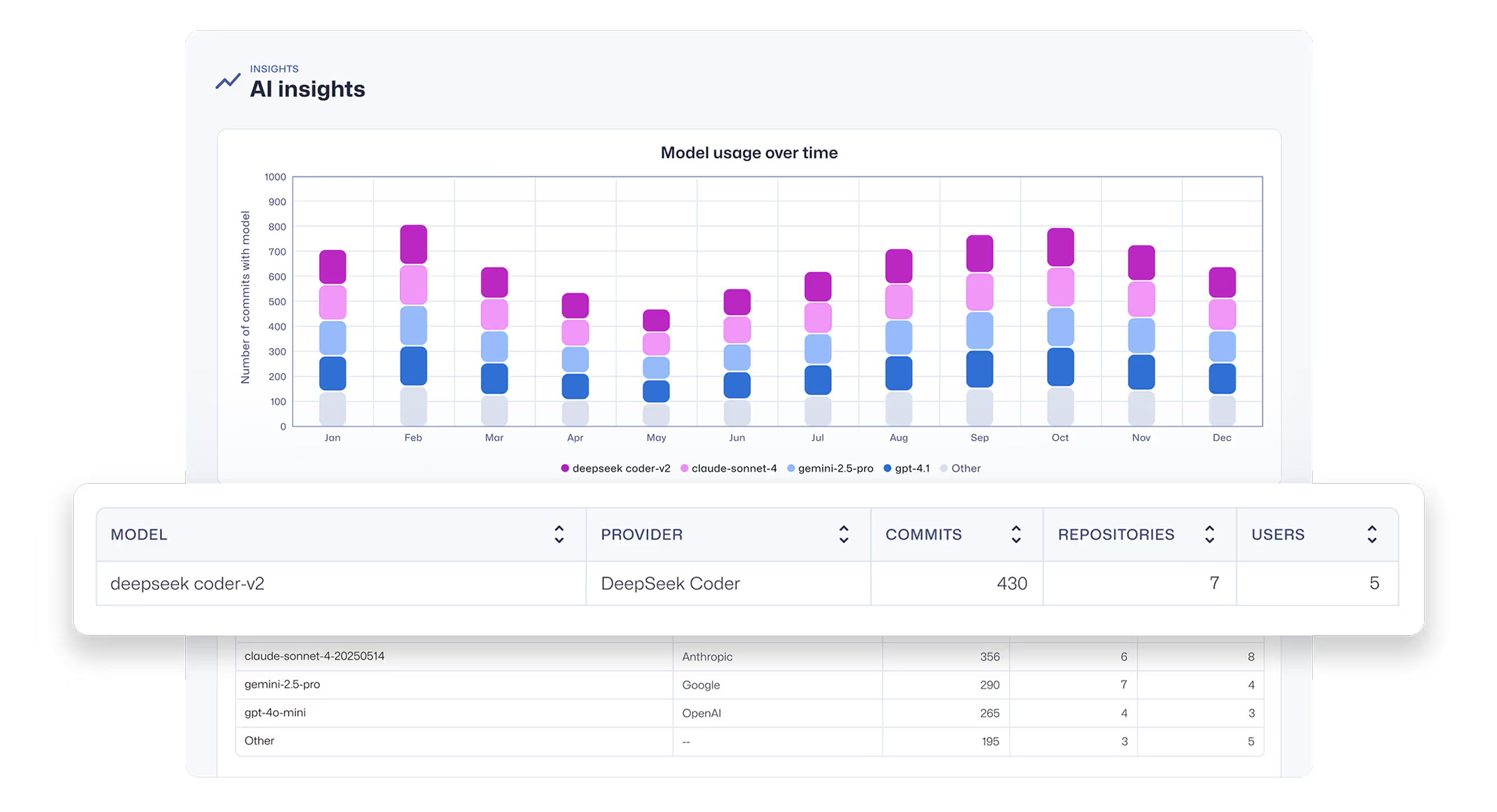

Verschaffen Sie sich einen umfassenden Überblick über KI-Codierassistenten und -agenten sowie über die LLMs, die sie antreiben. Entdecken Sie nicht zugelassene Tools und Modelle.

Tiefgreifende Beobachtbarkeit von Übertragungen

Verschaffen Sie sich einen umfassenden Einblick in die KI-gestützte Softwareentwicklung, einschließlich der Frage, welche Entwickler welche LLM-Modelle und MCPs verwenden und auf welchen Codebasen.

Integrierte Governance und Kontrolle

Verknüpfen Sie KI-generierten Code mit tatsächlichen Übertragungen, um das tatsächliche Sicherheitsrisiko zu verstehen, das eingeführt wird. Automatisieren Sie die Durchsetzung von Richtlinien, um sicherzustellen, dass KI-gestützte Entwickler sichere Codierungsstandards erfüllen, bevor ihre Beiträge akzeptiert werden.

Fragen zum Trust Agent: AI-Einblicke

Warum sollte ich mich um die Risiken von KI/LLM-generiertem Code in meinem SDLC kümmern?

Da Entwickler zunehmend KI-Codierungstools einsetzen, wird eine kritische neue Risikoebene in SDLCs eingeführt. Umfragen zeigen, dass inzwischen 78 % der Entwickler diese Tools verwenden, doch Studien zeigen, dass bis zu 50 % des von KI erzeugten Codes Sicherheitslücken enthält.

Dieser Mangel an Governance und die Diskrepanz zwischen dem Wissen der Entwickler und der Codequalität kann schnell außer Kontrolle geraten, da jede unsichere, von KI generierte Komponente die Angriffsfläche Ihres Unternehmens vergrößert und die Bemühungen um Risikomanagement und Compliance erschwert.

Lesen Sie mehr in diesem Whitepaper: KI-Codierassistenten: Ein Leitfaden zur sicherheitsgerechten Navigation für die nächste Generation von Entwicklern

Welche Modelle und Tools kann Trust Agent: AI erkennt?

Vertrauensagent: AI sammelt Signale von KI-Assistenten und agentenbasierten Codierungstools wie GitHub Copilot, Cline, Roo Code usw. und den LLMs, die sie antreiben.

Derzeit erkennen wir alle Modelle, die von OpenAI, Amazon Bedrock, Google Vertex AI und Github Copilot bereitgestellt werden.

Wie wird Trust Agent: AI installiert?

Wir stellen Ihnen eine .vsix-Datei für die manuelle Installation in Visual Studio Code zur Verfügung. Die automatische Bereitstellung über MDM-Skripte (Mobile Device Management) für Intune, Jamf und Kanji wird in Kürze folgen.

Wie melde ich mich für Trust Agent: AI?

Trust Agent: KI befindet sich derzeit in der Beta-Phase. Bei Interesse tragen Sie sich bitte in unsere Warteliste für den frühen Zugang ein .

Ressourcen für den Einstieg

Sicheres Coding im Zeitalter der KI: Testen Sie unsere neuen interaktiven KI-Herausforderungen

KI-gestütztes Coding verändert die Entwicklung. Testen Sie unsere neuen KI-Herausforderungen im Copilot-Stil, um Code in realistischen Workflows sicher zu prüfen, zu analysieren und zu korrigieren.

Vibe Coding: Praktischer Leitfaden zur Aktualisierung Ihrer AppSec-Strategie für KI

In diesem On-Demand-Video erfahren Sie, wie AppSec-Manager durch einen praktischen Ansatz, bei dem die Schulung im Vordergrund steht, in die Lage versetzt werden, KI zu fördern, anstatt sie zu blockieren. Wir zeigen Ihnen, wie Sie Secure Code Warrior (SCW) nutzen können, um Ihre AppSec-Strategie strategisch für das Zeitalter der KI-Codierassistenten zu aktualisieren.

KI-Codier-Assistenten: Ein Leitfaden zur sicherheitsgerechten Navigation für die nächste Generation von Entwicklern

Große Sprachmodelle bieten unwiderstehliche Geschwindigkeits- und Produktivitätsvorteile, aber sie bringen auch unbestreitbare Risiken für das Unternehmen mit sich. Herkömmliche Sicherheitsleitplanken reichen nicht aus, um die Flut zu kontrollieren. Entwickler benötigen präzise, geprüfte Sicherheitskenntnisse, um Sicherheitslücken bereits zu Beginn des Softwareentwicklungszyklus zu erkennen und zu verhindern.

Ressourcen für den Einstieg

Cybermon ist zurück: Besiege den Boss Missions auf Abruf verfügbar

Cybermon 2025 Beat the Boss ist jetzt ganzjährig in SCW verfügbar. Setzen Sie fortschrittliche KI-/LLM-Sicherheitsherausforderungen ein, um die sichere KI-Entwicklung in großem Maßstab zu stärken.

KI kann Code schreiben und überprüfen – aber das Risiko tragen weiterhin die Menschen.

Die Einführung von Claude Code Security durch Anthropic markiert einen entscheidenden Schnittpunkt zwischen KI-gestützter Softwareentwicklung und der rasanten Weiterentwicklung unserer Herangehensweise an moderne Cybersicherheit.

Das Gesetz zur Cyber-Resilienz erklärt: Was es für die Entwicklung sicherer Software bedeutet

Erfahren Sie, was das EU-Gesetz zur Cyberresilienz (CRA) vorschreibt, für wen es gilt und wie sich Entwicklerteams mit Secure-by-Design-Praktiken, Schwachstellenprävention und dem Aufbau von Entwicklerkompetenzen darauf vorbereiten können.

.avif)

.avif)